Geballtes Wissen rund um Suchmaschinenoptimierung gab es im November 2018 wieder auf der SEOkomm in Salzburg. Hochkarätige Branchen-Experten gaben in vielfältigen Sessions ihr Wissen weiter und regten zu einem Austausch rund um aktuelle SEO Themen und Trends an. Ein gelungener Jahresabschluss der Online-Marketing- und SEO-Branche in Salzburg.

Inhaltsverzeichnis

- Keynote: Codename: Kona. Play!

- Google Data Studio Hacks & SEO Dashboards

- Data-driven Technical SEO: 20+ Tipps, um das Beste aus Logfiles herauszuholen

- Shop SEO: Durch Datenanalyse zu besseren Rankings

- Winning Featured Snippets – Practical Insights from Sixt

- Der Relevanzfaktor: Der richtige Content für dein Thema

- JavaScript SEO – a guided tour

- Was du von Suchmaschinen über SEO lernen kannst

- Fazit

Keynote: Codename: Kona. Play!

Marcus Tandler zeigte in seiner Keynote einige Ausblicke zu den aktuellen Entwicklungen rund um Google, SEO und Co.

Zunächst betrachtete Marcus am Beispiel von ryte.com die Auswirkungen des Medic-Updates. Zu Anfang verschlechterte sich die Sichtbarkeit für das gesamte Portal. Laut Marcus handelte es sich bei den aus dem Ranking gefallenen Seiten um genau jene Seiten, die zwar angezeigt aber nicht geklickt wurden. Hier legte Marcus zugrunde, dass es sich um eine qualitative Aufwertung der Top 10 Suchergebnisse handelt, weshalb Seiten ohne Klicks auf Seite 2 zurückfallen oder ganz aus dem Ranking verschwinden. Nach dem Einbruch der Sichtbarkeit ging es durch qualitativ hochwertigere Rankings jedoch schnell wieder bergauf in der Sichtbarkeit.

Auch die Änderungen in der Google Search Console nahm Marcus näher unter die Lupe. So setzt die neue Search Console ein Zeichen gegen SERP Scraping durch Keyword-Monitoring-Tools. Die Tools sorgen durch viele und große Abfragen für eine verlängerte Ladezeit, weshalb Google selbst gegen das Scraping vorging und so durch eine Maßnahme einmal fast ganz Frankreich von Google gesperrt hat. Neben dieser Anekdote verdeutlichte Marcus, dass die neue Search Console in den Daten wesentlich genauer ist, als andere Tools. Je nach Tool ist die Herangehensweise anders und die Daten zu Keywords und Search Performance unterscheiden sich z.T. stark.

Außerdem zeigte Marcus auf, dass die Zukunft der Sprache gehört. Google wird zukünftig zum Gesprächspartner und lernt den Nutzer zu verstehen. Um zukünftig das beste Suchergebnis liefern zu können, werden granulare Informationen immer wichtiger. Die Zukunft gehört der Optimierung von Informationen anstatt gesamter Websites, laut Marcus. Aus diesem Grund liegt der Fokus auf qualitativ hochwertigen Inhalten, die in unterschiedlichsten Formaten für den Nutzer aufbereitet sind. Auch Video-Inhalt wird Google zukünftig interpretieren können.

Das Zusammenstecken mehrerer Informationsblöcke zu einem gesamten Content-Raster wird immer wichtiger. Google indexiert künftig einzelne Inhaltsfragmente (Entities) und steckt diese entsprechend der Suchanfragen zu einem Suchergebnis zusammen. Durch diese Änderung ergibt sich schließlich, dass wir keine Trennung des Indexes nach Sprachen mehr haben, sondern hier vor allem für übergreifende Suchanfragen aus z.B. dem Bereich Wetter und Events einfach die passenden Informationsfragmente zusammengetragen und dem Nutzer präsentiert werden, sodass der Nutzer eine Kombination der besten Information unabhängig von der Quelle erhält. Aber Marcus gibt im Rahmen dieser Skizze auch zu bedenken, dass aus Google-Sicht momentan die Sprache noch zu komplex ist und Google zunächst lernen muss, die einzelnen Entitäten auf den Websites zu verstehen.

Was ist also zukünftig zu tun: Marcus setzt hier auf die Strukturierung von Daten (JSON-ID, schema.org) und die Erhöhung der Attraktivität von Websites. Qualitativ hochwertiger Content wird somit wichtiger denn je.

Google Data Studio Hacks & SEO Dashboards

Unsere Kollegin Bernadette Hohns hat sich in ihrer Session dem Thema Google Data Studio angenommen und wertvolle Tipps und Tricks rund um das Aufsetzen und Bearbeiten von Dashboards in Google Data Studio gegeben. Als kleinen Bonus hat sie ein SEO-Dashboard mit den wichtigsten KPIs zusammengestellt.

Zunächst zeigte Bernadette die Vorteile des Google Data Studio gegenüber den herkömmlichen Auswertungsmöglichkeiten auf. Neben einem visuell ansprechenden Design sind vor allem Vorteile wie das Zusammenstellen von Daten aus mehreren Quellen und die Interaktivität der Berichte nennenswert. Dabei ist das Aufsetzen eines Berichtes zunächst nicht sehr schwer: Nach der Anmeldung im Konto kann ein leerer Bericht oder ein Template angelegt werden und es muss nur noch die Datenquelle verbunden und ausgewählt werden. Schon geht es los mit der Erstellung von Berichten. Die Datenquellen können dabei ganz unterschiedlich sein: Von den gängigen Google Produkten wie Google Analytics, Google Ads und der Google Search Console, können auch Partner wie Facebook, oder Datenbanken wie Big Query verbunden werden.

Jedoch gibt Bernadette zu beachten, dass bei den Umsetzungen von Berichten durch die vielfältigen Möglichkeiten auch ein paar Fallstricke lauern. Um die größten Fallstricke zu umgehen, hat sie u.a. ihre 10 Hacks zusammengestellt:

- Plant euren Bericht und was ihr auswerten möchtet

- Datenzugriff gewähren – legt fest, wer bearbeiten und wer betrachten darf

- Nutzer Verlaufsdiagramme zur Visualisierung – hier fallen schnell Schwankungen auf

- Kombiniert mehrere Datenquellen in einem Dashboard um Zusammenhänge aufzuzeigen

- Nutzt die Zeitraum- und Filtersteuerung – auch Betrachter können so unterschiedliche Zeiträume und Datenbereiche betrachten

- Erstellt mehrere Seiten für umfassende Reports und clustert Auswertungen nach Bereichen – so bleibt alles übersichtlich

- Verwendet sprechende Benennungen für Dimensionen und Metriken – diese können individuell umbenannt werden, sodass sie für Betrachter eindeutig verständlich sind

- Erstellt Vorlagen – gerade was Layout und Design angeht, müsst ihr so nicht immer von vorne beginnen

- Nutzt berechnete Felder, um eure Daten zu kombinieren und so neue Auswertungsmöglichkeiten zu schaffen

- Fügt Datenquellen in einem Diagramm zusammen, um neue Sichtweisen auf Daten zu erhalten – Bsp. Kombination Analytics- und SearchConsole- Daten

Wenn ihr Fragen zum Data Studio habt, wendet euch gerne an unser Team von Luna-Park oder an Bernadette selbst.

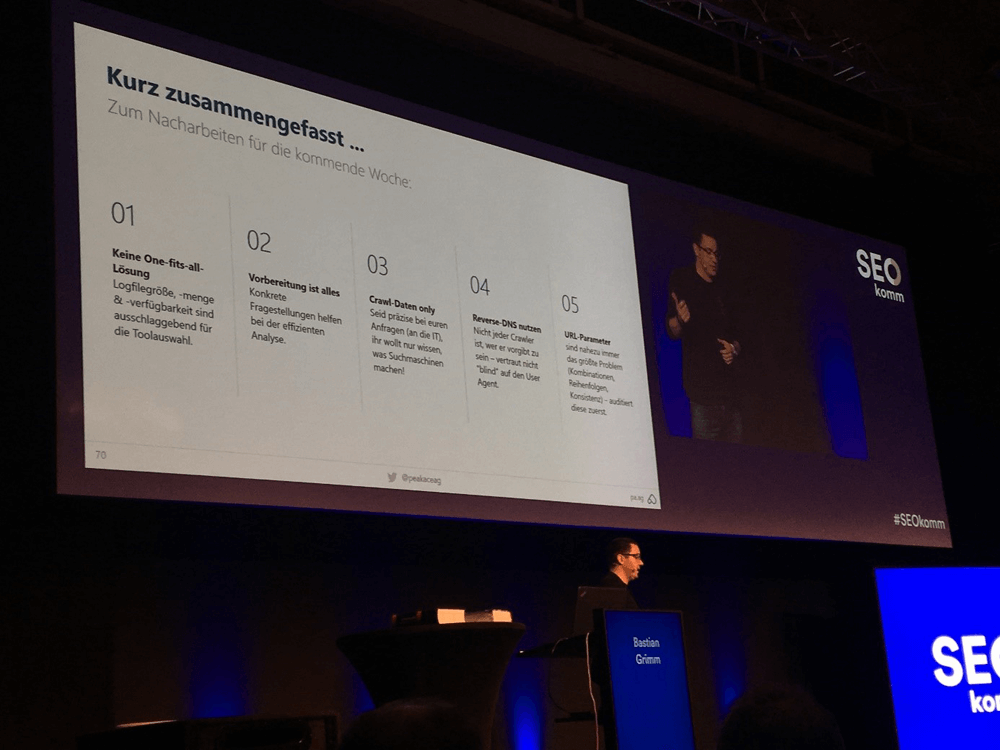

Data-driven Technical SEO: 20+ Tipps, um das Beste aus Logfiles herauszuholen

In seiner Session führte Bastian Grimm seine Zuhörer in das Thema Logfile-Analyse ein. Logfiles können ein mächtiges Tool zur Bewertung von Websites sein. Während Crawling-Tools das Crawling simulieren, erhält man im Logfile die echten Daten und kann herausfiltern, welche Inhalte wann und wie oft gecrawlt wurden.

Aus den Daten lassen sich Prioritäten zwischen URLs ableiten und Fehler erkennen. Außerdem können wir nachvollziehen, ob das Crawling optimal verläuft und z.B. Änderungen oder neue Inhalte schnell gefunden werden.

Bastian gab hier zu bedenken, dass sich bei einem Vergleich von Daten aus Google Analytics und den Logfiles diese unterscheiden werden. Ein weiterer Tipp von Bastian: Fragt bei der Anfrage an eure IT nach den Logfiles richtig nach – ihr benötigt hier keine personenbezogenen Daten und ihr solltet die Daten aus allen Orten bekommen (serverseitig und auch aus dem Cache z.B.).

Bastian Grimm auf der SEOkomm 2018

Anschließend stellte Bastian einige Tools vor, mit denen Logfile Analysen durchgeführt werden können und erklärte, was man sich im Rahmen einer Logfile Analyse anschauen sollte:

- Gibt es Anomalien im Verlauf?

- Welche Bots besuchen die Website?

- Vergleich Smartphone vs. Desktop Crawling

- Welche Landingpages werden wie oft gecrawlt

- Status Codes

- Prioritäten ansehen und vergleichen (welche Inhalte oft, welche selten gecrawlt?)

- Crawl-Budget Nutzung und Waste (gibt es Parameter-Probleme?)

- Überprüfung Crawling index und noindex

- Gecrawlte Seiten vs. Seiten in Sitemap

- Bildoptimierung (Dateigrößen)

Hier gibt es sehr viele Möglichkeiten der Auswertung, deshalb empfiehlt Bastian, dass man sich zuvor überlegen soll, was genau man anschauen möchte. Hat man sich einen Fahrplan zurechtgelegt, ist eine Logfile-Analyse aber eine gute Möglichkeit sich dem Thema Crawling auf der eigenen Website zu nähern.

Shop SEO: Durch Datenanalyse zu besseren Rankings

In seiner Session gab Stephan Czysch viele wertvolle Tipps rund um Shop SEO. Um einen Shop gut optimieren zu können, muss zunächst ein Ziel für die Optimierung gesetzt und eine Strategie definiert werden. Ohne diese Basis ist es schwer, gut zu optimieren. Stephan stieg dann ein in das Vorgehen der Optimierung.

Am Anfang der Optimierung stehen so die passenden Keywords, die es für den Shop und die Produkte zu platzieren gilt. Hier ist es besser je spezifischer die Keywords ausgewählt werden. Eine allgemeine Optimierung auf „Anzüge“ ist demnach nicht so erfolgreich, wie eine Optimierung auf „Nadelstreifen-Anzug“. Das Keyword muss zum Produkt passen und es möglichst genau beschreiben. Bei der Keywordanalyse kann auch eine Verknüpfung von SEO und SEA helfen.

Nachdem wir alle Keywords beisammen haben, empfiehlt Stephan zu überprüfen, ob zu diesen Keywords bereits ein Ranking vorhanden ist. Anhand eines Keyword-Mapping kann so identifiziert werden, ob und wozu Keywords gefunden werden, und ihr könnt die Map nutzen, um den Überblick über die Optimierung und Zuordnung zu behalten.

Stephan Czysch über Shop SEO

Stephan gab noch einige Tipps für Quellen zur Keywordanalyse:

- Wettbewerber als Ideengeber

- Sales Trends (was wird gut verkauft?)

- Search Suggest für Keywords

- Interne Suche für Keywords

Zudem machte Stephan auf ein wesentliches Problem aufmerksam: Im Bereich der Produkt-Rankings ergibt sich die Schwierigkeit, dass diese auch zeitweise nicht verfügbar sein können und oft nur wenig Inhalt für die einzelnen Produkte zur Verfügung stehen. Deshalb ist es wichtig, sich Gedanken zur Strategie zu machen, wo der Nutzer auf der Seite einsteigen soll: Vielleicht ist es sinnvoller, ihn über eine Verteilerseite abzuholen, anstatt ihn über eine Produkt-Landingpage abzuholen.

Neben der richtigen Keyword-Strategie und Ansprache der Nutzer ist aber auch die interne Verlinkung ein wesentlicher Faktor, wie Stephan darlegte. Es lohnt sich die interne Verlinkung zu stärken und die Struktur auszubauen, um wichtige Seiten zu pushen und sowohl für Crawler als auch für Nutzer leichter auffindbar zu machen. Werft deshalb einen Blick auf die Top Ebene, meist fangen diese in der Hauptnavigation an, und vergleicht das mit den für euch wichtigen Seiten. Hier kann sich weiteres Optimierungspotential ergeben. Neben der Verlinkung an sich spielen auch die Ankertexte eine wichtige Rolle. Diese sollten ebenfalls passend für die verlinkte Seite optimiert sein.

Als letzten großen Baustein gab Stephan noch einen Einblick in die Snippet-Optimierung. Anhand von z.B. der CTR legt Stephan, die zu optimierenden Seiten fest und steigt anschließend in die Optimierung der Snippets ein.

Winning Featured Snippets – Practical Insights from Sixt

In ihrer Session warf Izzi Smith einen Blick auf die Featured Snippets, die momentan eines der aktuellen Trendthemen darstellen. Die Rankings auf der sogenannten Position Zero ermöglichen die Platzierung auf einem prominenten Platz und sorgen neben Aufmerksamkeit auch für gesteigerte Traffic-Werte.

Die Ergebnisse, die hier platziert werden, sind für Google besonders wertig und treffen das Nutzerinteresse in hohem Maße. Izzi machte in diesem Zusammenhang auch darauf aufmerksam, dass man durch die Featured Snippets eine bessere Position als der Wettbewerb einnehmen kann, auch wenn dieser in der organischen Suche besser rankt als man selbst, insofern Google die Information auf der eigenen Seite als wertiger einstuft. Hier zeigte sich einmal mehr der Fokus auf wertigen Inhalt und das Optimieren von Informationen, wie es Marcus Tandler bereits in seiner Keynote aufgezeigt hat.

Außerdem spielt im Rahmen der Voice Search das Featured Snippet eine wesentliche Rolle. Der Assistent liest immer das erste Ergebnis aus und somit zu vielen Suchanfragen eben das Featured Snippet.

Im Fokus stehen laut Izzi hier die passenden Keywords bzw. Modifier für Keywords, die das Ranking als Featured Snippet begünstigen. Diese Keywords und Modifier sind:

- Fragen (vornehmlich W-Fragen)

- Präpositionen (mit, ohne, ähnlich)

- Vergleiche (besser, schlechter)

In einem ersten Schritt kann man sich die vorhandenen Rankings anschauen und evaluieren, ob hier bereits Keywords mit Modifiern vorhanden sind. Zusätzlich sollte dann weiteres Potential analysiert werden. Ein Tool-Tipp von Izzi: Answer-the-Public.

Außerdem kann auch das Sales-Team wichtige Hinweise liefern. Sie sind das Ohr zum Kunden und können einen Überblick über typische Fragen o.ä. geben.

Izzi Smith auf der SEOkomm 2018

Neben der Identifikation relevanter Fragestellungen und Keywords ist es aber auch wichtig, sich über die Aufbereitung des Inhalts Gedanken zu machen. Izzi vergleicht hier die Notwendigkeit holistischer Inhalte mit der für spezifische Aufbereitungen. Der holistische Ansatz lohnt sich vor allem dann, wenn wir Cluster-Themen haben, für die sich eigene Seiten nicht lohnen und die einzelnen Themen dann von der Stärke eines Clusters profitieren. Jedoch soll der Inhalt auch nicht zu lang werden. Insofern es sich um ein erklär-bedürftiges Thema handelt, zu dem Inhalte vorhanden sind, lohnt es sich eine spezifische Themenseite aufzubereiten. Jedoch sollten zu kleinteilige Unterseiten mit nur knappen Inhalten vermieden werden.

Izzi zeigte hier ein anschauliches Beispiel von FAQ-Seiten: in einem Fall wurden alle FAQ-Beiträge auf einer sehr langen Seite gesammelt – das Gegenbeispiel war dann die Darstellung von FAQs mit entsprechender Beantwortung in ein oder zwei Sätzen auf einzelnen eigenständigen Unterseiten. Hier lohnt es sich nach Themen zu clustern und die Inhalte aufzubereiten. Wichtig ist es auch hier, gute Inhalte für Nutzer zu produzieren, die relevant für das Nutzerinteresse sind.

Um Google die Ausspielung eines Featured Snippets zu den eigenen Inhalten zu erleichtern, sollten die Inhalte bereits so aufbereitet sein, wie Google sie später auch Anzeigen soll. Für die einzelnen Formen eines Featured Snippet (Paragraph, Tabelle, Liste) gibt es entsprechende Aufbereitungen des Contents. Izzi riet hier unterschiedliche Aufbereitungen auszuprobieren und zur Verfügung zu stellen. So nahm Sixt das Thema Featured Snippets z.B. zum Anlass die Produktseiten der Automodelle zu überarbeiten, um hier ein Ranking positiv zu beeinflussen.

Für das Ausspielen von Paragraphen eignen sich besonders Fragen, die kurz und bündig beantwortet werden. Listen hingegen erfordern eine klare Struktur der Seite, so können auf der Seite platzierte und ausgezeichnete Listen ausgespielt werden, aber z.B. auch eine Strukturierung aus H2 Überschriften abgeleitet werden.

Besonders wichtig ist es jedoch laut Izzi sich als Experte in seinem Themenfeld zu beweisen und den besten Inhalt mit den besten Formaten zur Verfügung zu stellen.

Ein unterstützendes Element im Rahmen der Featured Snippets ist die Auszeichnung per Schema.org. Izzi hat hier in der Optimierung bei Sixt gute Erfahrungen gemacht. Mit Hilfe der strukturierten Daten bzw. Auszeichnung kann Google Inhalte noch besser zuordnen.

Der Relevanzfaktor: Der richtige Content für dein Thema

In seiner Session legte Martin Höllinger den Fokus auf den Relevanzfaktor von Inhalten. So sollte immer der Nutzer im Fokus der Optimierung stehen und nicht mehr die Suchmaschine. Der Hintergrund ist dabei schnell erläutert:

- Google möchte dem Nutzer relevanten Inhalt liefern

- Nutzer haben ein Problem und suchen hierzu eine Lösung

- Websitebetreiber möchten Nutzer erreichen und im Idealfall „Geld verdienen“

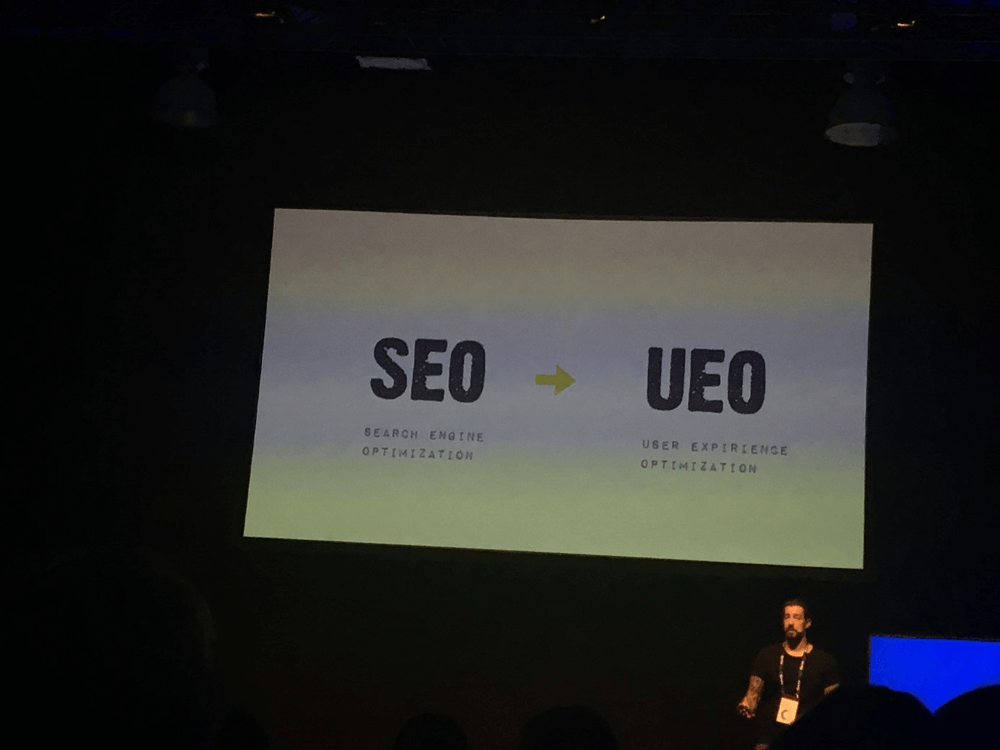

Deshalb ist die Zielgruppe hier ganz klar der Nutzer. Martin plädiert deshalb für die Umbenennung von SEO (Search-Engine Optimization) hin zu UEO (User-Experience Optimization).

Martin Höllinger über relevanten Content

Die Basis für die Optimierung bleibt aber auch für Martin das klassische SEO. Neben der Website-Architektur, relevanten Inhalten, Pagespeed und Links sind auch Faktoren wie die Indexsauberkeit wichtig. Hier sollten wir uns die Fragen stellen, wie viele der indexierten Inhalte wirklich relevant sind. Durch die Optimierung indexierter Seiten und das Aufräumen des Indexes können wir sicherstellen, dass nur relevante Seiten im Index sind. Crawling kostet Google Geld, weshalb es von Vorteil ist, nur relevante Inhalte im Index zu platzieren.

Martin nahm sich an dieser Stelle der Frage an, wie relevante Inhalte identifiziert werden können. Zum einen lohnt sich, laut Martin, der Blick in die Google SERPs, zum anderen ist die Betrachtung der User-Signals wichtig. Aber auch der gesunde Menschenverstand kann hier Aufschluss geben. Bei der Frage nach dem Inhalt spricht Martin nicht nur von Texten sondern auch Bildern, Videos und Co. Nicht immer ist der Text das Nonplusultra. Dazu führte Martin das Beispiel zur Suche nach „Trendfrisuren 2018“ an. Hier werden dem Nutzer zuerst Bilder präsentiert. Es lohnt sich also eher den Nutzer mit Bildern auf die Website zu holen und diese hier gut aufbereitet zu präsentieren, anstatt ihm einen langen Text ohne Bilder o.ä. zu bieten. Die Überlegung sollte also immer sein: Was erwartet der Nutzer? Die Google Suche bzw. die SERPs können so schon ersten Aufschluss darüber liefern, was relevanter Content für den Nutzer ist und dient uns als Learning für unsere Inhalte.

Im Bereich der Nutzersignale legte Martin ein starkes Augenmerk auf die Time on Site, Absprungrate und die Seiten pro Sitzung. Auf Basis unterschiedlicher Seitentypen können hier Rückschlüsse auf etwaige Optimierungen gezogen werden.

In der Optimierung regte Martin dazu an, vorhandene Inhalte zu nutzen. Gibt es beispielsweise schon einen Ratgeber-Text zu Trendfrisuren, ist es ein Leichtes diesen um eine Bildergalerie zu ergänzen. So werden vorhandene Inhalte wertiger und leicht optimiert. Das Ziel sollte langfristig sein, dass nur noch relevante Inhalte im Index sind. Dabei sollte man sich immer die Frage stellen, ob die eigenen Inhalte sinnvoll und passend sind.

JavaScript SEO – a guided tour

Martin Splitt nahm uns in seiner Session mit in die Welt des JavaScript SEO. Zu Beginn des Vortrags zeigte Martin auf, welche Entwicklung JavaScript die letzten Jahre erlebt hat. JavaScript ist dabei ein Name für viele Dinge und wird vielfältig eingesetzt. Am Anfang sollte es nur serverseitig eingesetzt werden, fand sich dann aber auch im Quellcode von Websites wieder. Hier war aber zuerst der gesamte Inhalt weiterhin im Quellcode vorhanden und JavaScript diente lediglich für die Kosmetik, also um Effekte o.ä. einzubinden.

Heute ist die Verwendung noch umgreifender: Über JavaScript werden ganze Inhalte auf Websites nachgeladen, sodass über den Quellcode direkt nur noch das bloße Gerüst einer Seite zur Verfügung gestellt wird und der eigentliche Inhalt über JavaScript ausgelagert ist und nachgeladen wird. Ein Beispiel für solche Umsetzungen sind dynamische Single Page Apps.

Dabei gibt es Unterschiede im Rendering von Seiten. Zum einen gibt es das Client Side Rendering. Hier wird nach der Anfrage an den Server zunächst das Gerüst der Seite geladen. Nach und nach stellt dann der Client über JavaScript weitere Anfragen an den Server, sodass in mehreren Schritten über JavaScript alles geladen wird. Hierbei ist die erste Antwort zwar schnell, aber dem Client stehen durch das JavaScript abfragen und rendern erst nach und nach alle Inhalte zur Verfügung, je nachdem wie viel über JavaScript ausgelagert ist.

Zum anderen gibt es das Server-Side Rendering. Hier werden alle Inhalte bereits auf dem Server geladen und bei einer Anfrage dem Client sofort komplett ausgespielt. Hier gibt es kein Nachladen und es ist alles auf einmal da. Diese Form ist sehr schnell und dem Client stehen sofort alle Daten zur Verfügung.

Zudem gibt es noch eine dritte Form, die eine Mischung der beiden genannten Varianten darstellt: das so genannte Hybrid-Rendering.

Mit diesem Wissen als Basis erklärte Martin nun wie Google funktioniert: Der Crawler kommt auf eine Seite und beginnt den HTML-Code auszulesen. Den Links, die er hier findet, folgt er und stellt die URLs zum folgenden Crawling hinten an. Dann schließt sich irgendwann das Rendering an und JavaScript wird ausgelöst. Sobald alles geladen ist, indexiert Google die Inhalte. Wichtig ist, dass Crawler und Renderer zwei unterschiedliche Instanzen sind. Je nachdem wie Inhalt aufbereitet ist und was an JavaScript benötigt wird, kann der Crawler schon mehr oder weniger Inhalt erfassen. Aus diesem Learning ergibt sich auch, dass Client-Seitiges Rendern schlechter ist, da der Crawler hier nur ein Gerüst der Seite erfasst und zuerst der Renderer vorbeikommen muss, um die Inhalte abzurufen. Im Gegensatz dazu kann beim Server-Seitigen Rendering bereits der Crawler alle Daten erfassen.

Wichtige Inhalte sollten dem Crawler also so einfach wie möglich zugänglich gemacht werden.

Martin Splitt auf der SEOkomm 2018 in Salzburg

Martin zeigte noch einige spannende Beispiele für die Umsetzung von JavaScript. Eines dieser Beispiele war die Umsetzung von noindex mit Hilfe von JavaScript. In diesem konkreten Fall ging es um einen Online-Shop, der sehr viele Produkte hatte. Da nicht alle Produkte in den Index sollten, wurden die Produktdetailseiten alle auf noindex gesetzt und für die wichtigen Produkte per JavaScript die Anweisung des noindex überschrieben. Problem: der Crawler besuchte die Seite und fand auf allen ein noindex-Tag vor, deshalb wurden die Seiten nicht weiter gecrawlt und indexiert und somit auch nicht gerendert, weshalb die Information über JavaScript, dass einige Produkte eben doch indexiert werden sollten, nicht ausgelesen wurde.

Die Umsetzung von JavaScript sollte deshalb unter die Lupe genommen werden und kann an der ein oder anderen Stelle auch zum Problem werden.

Was du von Suchmaschinen über SEO lernen kannst

Thomas Mindnich startete seine Session mit einem kurzen Rückblick auf seinen Vortrag aus dem Jahr 2017 und fasste die Learnings noch einmal zusammen: Im Fokus stand hier Termgewichtung, Main-Content, Suchabsichten und das Treffen des Themas. Dieses Jahr baute Thomas auf diesen Learnings auf und warf einen tieferen Blick auf Googles Patente, Suchabsichten und Co.

Die Betrachtung der Suchabsichten entlang der Customer Journey ist ein wichtiger Baustein zur erfolgreichen Aufbereitung von Inhalten. Google geht in der Sichtweise von Suche und Websites von den eigenen Quality Rater Guidelines aus. Demnach steht Relevanz immer in Konkurrenz zu Pertinenz: Jeder Nutzer ist anders und für jeden ist etwas anderes relevant, sinnvoll und nützlich. Der Mehrwert für den Nutzer steht im Fokus aller Betrachtungen.

Das ist zugleich für Thomas der Grund, weshalb sich die Suche ändert. Da Google den Nutzer zufriedenstellen möchte und sich die Suchanfragen der Nutzer aber verändern, verändert sich auch die Suchmaschine, um den Nutzer weiter zufriedenstellen zu können.

Als Rankingfaktoren werden künftig deshalb Local Proximity und die Termbeziehung wichtiger. Je näher etwas ist im lokalen Bezug, desto besser ist es, und welche Keywords können wie ergänzt und in Beziehung gesetzt werden. Die richtigen Worte müssen also in einen passenden Kontext gesetzt werden.

Thomas legte anschließend dar, wie Google uns als Nutzer sieht. Aus Google Sicht verwenden wir oft falsche Worte in Suchanfragen, um richtige Ergebnisse zu erhalten. Google bedient sich deshalb dem Query Rewriting und korrigiert „falsche“ Suchanfragen mit Synonymen und Ergänzungen. Für diesen Mechanismus hat Google ein Patent. Durch das Rewriting stellt Google selbst nochmal passende Suchanfragen um die eigentliche Suchanfrage herum und scannt dann alle Inhalte im Web auf diese Terme. So ist das schlussendlich Suchergebnis, welches dem Nutzer ausgespielt wird, das Ergebnis auf Basis unzähliger Dokumente und Terme, aus denen Google nach Clustering die Top 10 Ergebnisse für die erste Seite ausgibt. Google sucht also selbst nochmal anhand von Synonymen und passenden Termen und stellt aus diesem Term-Cluster dann das entsprechende Suchergebnis aus den betrachteten/gefundenen Dokumenten zusammen, da der Nutzer selbst ja gar nicht so genau ausdrückt und weiß was er sucht.

Es ist also wichtig für Online-Marketer, sich mit den Patenten auseinanderzusetzen und diese zu verstehen, sodass sie die Learnings entsprechend umsetzen und passende Inhalte erstellen können, wie Thomas mit seinem Vortrag eindrucksvoll aufgezeigt hat.

Fazit

Wie schon in den letzten Jahren zeichneten sich die SEOkomm auch 2018 wieder durch eine sehr gute Organisation und hochkarätige Speaker aus. Die vielen spannenden Insights und Denkanstöße konnten in den kleinen Pausen zwischen den Sessions gleich mit Branchenkollegen oder den Speakern diskutiert werden. Zudem ließen die Pausen genügend Zeit um neue Kontakte zu knüpfen. Die Party am Abend bildete den gelungenen Abschluss einer erfolgreichen SEO Konferenz, die wir auch im nächsten Jahr gerne wieder besuchen. Vielen Dank an die Gastgeber Oliver und Uschi Hauser für solch gelungene Veranstaltungen!

Weitere Recaps