„TRANSFER OF KNOWLEDGE“ – unter diesem Motto fand am 19.08.2017 das erste Measure Camp 2017 in Kopenhagen statt. Rund 100 Analytics-Interessierte, von denen der Großteil männlich war, nahmen an der englischsprachigen Un-Konferenz teil. In sieben Slots mit jeweils sechs parallelen Sessions wurden aktuelle Themen im Bereich Analytics vorgestellt und diskutiert.

Wenn man die Un-Konferenz in ein paar Schlüsselwörter zusammenfassen wollte, dann wären dies:

- Machine Learning

- Automatisierung der Prozesse

- Data Science

- Big Query

- Viele technische Aspekte wie DataLayer / JavaScript / APIs

- Internet of Things (IoT)

- Campaign Measurement & Customer Journey

- Visualisation (Data Studio)

- Privacy

- Web Analytics Persona

Im Folgenden werden die Sessions vorgestellt, an denen ich teilgenommen habe.

Inhaltsverzeichnis

- Measurcamps weltweit

- Helper Tools for Tealium iQ by Peter Meyer (Senior Web Analytics Developer/Nordea)

- Analytics in the value chain of comms. measurement by Jesper Andersen (Quantum)

- Is BigQuery the answer to all digital analytics prayers? by Mark Edmondson

- Importing and utilizing offline data in digital analytics by Martin Muink Nielsen

- Google Analytics crash course by Peter O’Neill

- Form submits vs Thank you pages by Erik Lissel

- The future of behavioural analytics by Stephanie Perez

- Das Drumherum

Measurcamps weltweit

Zu Beginn in der Welcome Session zeigten Veranstalter Peter O’Neil und Ivan Bager (Product Unit Director bei Siteimprove) den Erfolg und die Weiterentwicklung der Mesurecamps weltweit auf. Inzwischen ist das Measure Camp die größte Analytics Konferenz der Welt.

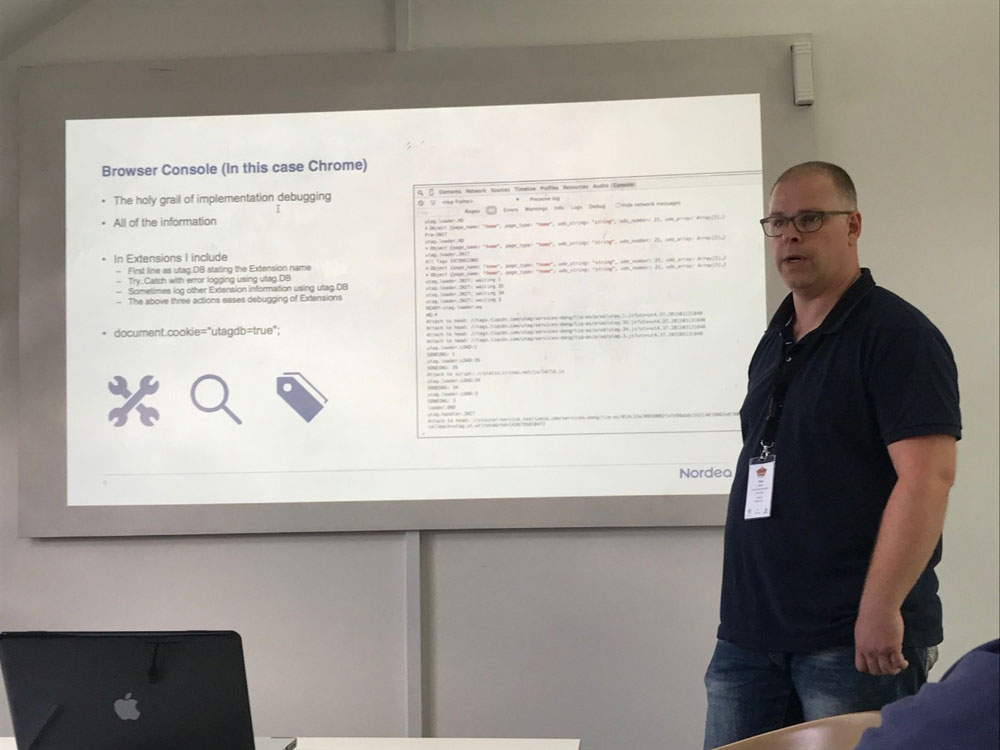

Helper Tools for Tealium iQ by Peter Meyer (Senior Web Analytics Developer/Nordea)

A discussion about availible helper tools for implementing and deploying Tealium iQ

Peter Meyer stellte diverse Plugins und sonstige Erweiterungen für besseres Testing und Deployment vor. Unter anderem waren dies:

- Browser Console

- Tealium Cistom Tools (z.B. Universal Tag Debugger, UDO Debugger, TiQ Switch)

- Open discussion (Requestly tool, Web Companion)

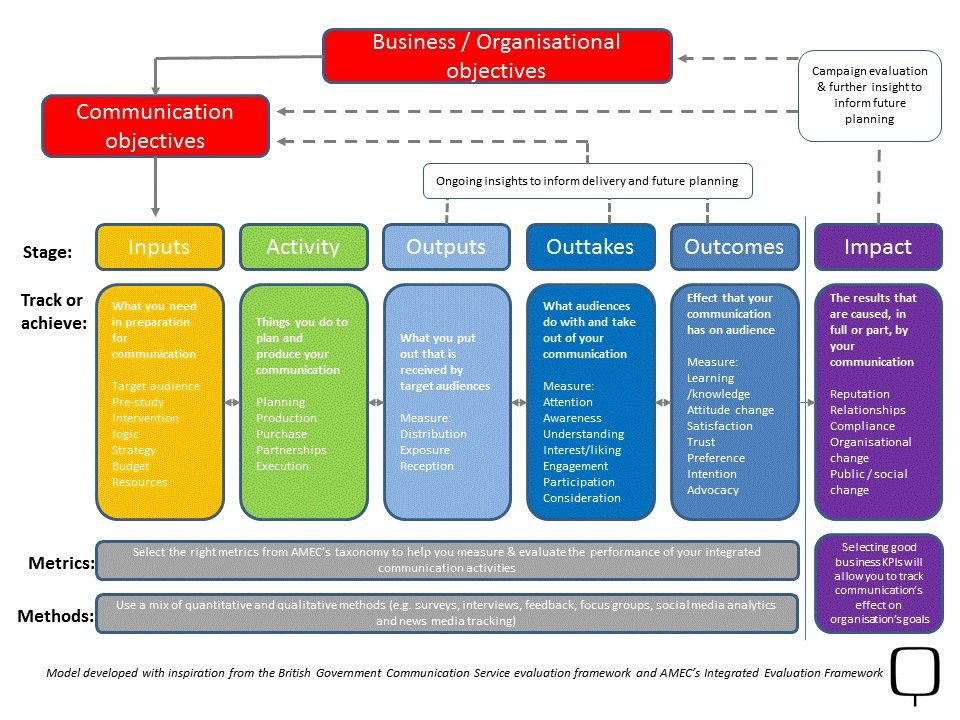

Analytics in the value chain of comms. measurement by Jesper Andersen (Quantum)

Online analytics are only a small (but important) part of measuring new communication creates a business impact. Perspectives from a PR measurement guy

Jesper Anderson stellte in seinem Vortrag das Modell für Analysen und Bewertung von Marketing Aktivitäten vor, das seiner Arbeit zugrunde liegt.

Kommunikations-Ziele und deren Stadien:

- „Input“ – Vor-Analysen, Recherche und Metriken-Setup (Empfehlung für Investition hier: 10-15% vom Gesamtbudget)

- „Activity“ – Produktion (Empfehlung für Investition hier: 70-80% vom Gesamtbudget)

- „Measurement“ – Analyse und Bewertung (Empfehlung für Investition hier: 10-15% vom Gesamtbudget)

- „Outputs“ (z.B. Messung der Social Media Reichweite, TV-Werbung etc.)

- „Outtakes“ (z.B. qualitative und quantitative Analysen der kurzfristig auf die Aktion folgenden Reaktionen und Aktivitäten der Zielgruppe(n), Kommentare in Social-Media-Kanälen, Bewertung des Grades der Bekanntheit / Engagement / Aufmerksamkeit)

- „Outcomes“ (z.B. qualitatives Feedback von den Zielgruppen / Surveys, Bewertung des Grades an Meinungs- und Einstellungsänderungen / Learning / Vertrauen / Präferenzen / Zufriedenheit etc.)

- „Impact“ (Analyse, inwieweit die gestellten Business-Ziele für die Kampagne(n) erreicht werden konnten, Bewegungen und Veränderungen im Business bzw. in der Organisation etc.)

Weiterführende Informationen zu Metrik-Beispielen, Taxonomie, Meilensteinen, Methoden und Analytics-Tools sind hier zu finden: https://amecorg.com.

Is BigQuery the answer to all digital analytics prayers? by Mark Edmondson

Big Query has helped solve a lot of problems in my work flow – coild it do the same for you? Go through problems and a BQ solution – are there better ways out there?

Mark Edmondson stellte BigQuery vor und ging dabei auf die Fragen nach Datenvereinigung, Datentransformation und Datenvisualisierung ein.

Er zeigte verschiedene Wege und Methoden für den Upload von Daten in die Big Query Cloud auf – z.B. anhand von Scripten, vom Transfer Service (Big Query UI), mit Hilfe des Streamings über Tag Manager etc. Man kann Daten von allen Arten von Quellen zu Big Query senden/streamen. Ob über SQL oder R – beide Arten von Requests sind möglich.

Am Ende empfahl er Google Data Studio als Visualisierungstool, vor allem basierend auf der natürlichen Verbindung über Connector zu BigQuery. Aber auch die meisten anderen Visualisierungstools verfügen über eine Anbindung zu BigQuery.

Importing and utilizing offline data in digital analytics by Martin Muink Nielsen

Let’s have a talk about seeing beyond our websites when we’re woking with understanding user experiences & KPIs. I’ll share some real life examples

Martin Muink Nielsen stellte diverse Beispiele für die erfolgreiche Einbindung von Offline-Daten in Google Analytics vor. Außerdem zeigte er den Vorteil von umfassenden digitalen Analysen auf, die anhand der weiteren User-Landschaft auch die Phasen vor und nach dem Digitalen berücksichtigen.

Hier sind einige praxisbezogene Beispiele:

- Wenn ein Rückruf-Formular ausgefüllt wird und ein User als Lead klassifiziert wird, wird diesem eine „transaction ID“ zugeordnet (basierend auf der Visitor-ID als Schlüssel). Diese ID wird zusammen mit allen Daten an das Call-Center weitergegeben und anschließend werden die Ergebnisse der Kommunikation zwischen dem User und dem Call Center Agenten über diesen Schlüssel zurück ins Analytics Tool gespielt (z.B. benutzerdefinierte Dimension „lead“, Ausprägung: gewonnen / verloren).

- Eine analoge Abwicklung erfolgt auch im Falle einer Kundenzufriedenheitsumfrage, die auf der eigenen Webseite ausgespielt, eigentlich aber von einem externen Dienstleister abgewickelt wird. Anhand von einer „transaction ID“ werden alle Daten wieder gematched und zusammengeführt für die Analysen im Analytics Tool.

Alle offline oder externen Datenassets für einen bestimmten User (z.B. aus dem CRM) können anhand von einer unique „user ID“ / transaction ID“ ins Analytics Tool importiert werden.

Google Analytics crash course by Peter O’Neill

25 tips in 30 mins across a range of areas

Peter O’Neil hat in seinem Crash Course die seiner Meinung nach 25 wichtigsten Tipps bei der Arbeit mit Google Analytics vorgestellt. Es waren sehr interessante Aspekte dabei und Peter hat es genau in den vorgesehenen 30 Minuten geschafft, uns seine Do’s und Dont’s vorzustellen.

- Understand the purpose of Digital Analytics

- Create a Google Analytics solution for non-analysts

- Invest time to understand information needs

- Track the most useful information first

- Be creative within your Google Analytics solution

- Record the Page URL and the Page Referrer

- Record the number of search results returned

- Record form validation errors

- Use all 5 Google Analytics custom campaign parameters (utm)

- Tell your vendors to add GA campaign parameters „If you can’t measure it, you can’t manage it“ (Peter Drucker)

- Don’t forget GA campaign tracking for Social Media

- Create GA goals for negative experiences

- Create a GA goal for all sessions

- Create a goal for each funnel checkpoint

- Create Calculated Metrics (completion rates) for each funnel stage

- Rename your pages in Google Analytics

- Record the type of each page (use as content grouping)

- Record the type of visitor

- Record product availability (Custom Dimensions)

- Record the basket value in a Custom Metric

- Peter‘s favourite report – pivot Entry Point vs. Medium

- Create a Performance Diagnostic report

- Create a tactical report for E-Commerce

- Create a tactical report for Publishers/Content

- Hit based segmentation is possible

[av_gallery ids=’29587,29588,29589,29590,29591,29592,29593,29594,29595,29596,29597,29598,29599,29600,29601′ style=’thumbnails‘ preview_size=’portfolio‘ crop_big_preview_thumbnail=’avia-gallery-big-crop-thumb‘ thumb_size=’portfolio‘ columns=’5′ imagelink=’lightbox‘ lazyload=’avia_lazyload‘ av_uid=’av-14cm0jw‘]

Form submits vs Thank you pages by Erik Lissel

How do we most accurately measure the most important thing on a web page? How do you handle form validations?

Problemstellung der Diskussionsrunde von Erik Lissel war die Frage, wie man am besten eine Conversion für ein Formular ohne Hilfe von Developer und Code-Anpassungen implementieren kann (via GTM).

- Option 1: Messen anhand der „Absenden“-Button-Klicks – Suboptimal als alleinige Lösung, da es Schwierigkeiten beim Abfangen des richtigen JavaScript-Event aufgrund von der automatischen Formular-Validierung Events geben kann.

- Option 2: Messen anhand der Aufrufe der Danke-Seite – Suboptimal als alleinige Lösung wegen multipler Neuladungen der Seite oder Bookmarks. Auch ein zusätzlicher Einsatz von markierendem User-Cookie, damit der User nicht bei Refresh oder Bookmark mehrmals gezählt wird, hilft nur ein bisschen weiter. Probleme tauchen auf, sobald der User die Cookies löscht, das Backend die Danke-Seite doch nicht ausliefert, der User zu schnell weiterklickt (GA nicht gefeuert) etc.

Weitere Hilfsimplementierungen – Timestamp und Referrals als Regel für die Verifizierung der „realen“ Danke-Seite Conversions nutzen.

- Option 3: Serverseitige Submit-Hits – Daten in Analytics und im Backend werden 1 zu 1 übereinstimmen, aber mögliche Problem beim Datentransport Backend <-> Frontend bleiben unerkannt.

- Empfehlung: Kombination aus Option 1 und 2 – Beides implementieren und regelmäßig mit den Backlogs vergleichen, um mögliche Probleme/Ausfälle in beiden Richtungen zu erkennen.

Am Ende gab Erik noch eine Empfehlung fürs Testing. Wenn die Developer und andere Tester nicht unbedingt durch die IPs gehen, die als interne Zugriffe über Analytics Filter im Tool herausgefiltert sind, könnte man noch zusätzlich eine interne Landingpage einrichten, über die sich alle erst einloggen oder einfach einsteigen müssen, sodass sie dort mit einem Cookie markiert werden und aus den Analytics Daten herausgefiltert werden können.

The future of behavioural analytics by Stephanie Perez

Open discussion about the future of behavioural analytics. What will we measure? What tools will we use?

Stephanie Perez führte eine Diskussion zu den Erfahrungen und Zukunftseinschätzungen der Teilnehmer zur Analyse des User-Verhaltens ein. Es wurde der Einsatz von diversen Tools wie Hotjar besprochen, wobei auch festgestellt wurde, dass aktuell keine Tools für Mobile Optimierung des User Verhaltens bekannt sind. Eine Herausforderung für die Heat Map Tools sind die native apps. Des Weiteren werden die Analysen dadurch erschwert, dass die Heat Map Auswertungen immer außerhalb vom Analytics Tools stattfinden (unabhängige Tools) und die Verknüpfung der Daten aktuell nicht optimal ist.

Der Wunsch nach Automatisierung der Prozesse und dem Einsatz von machine learning / Künstliche Intelligenz für die Personalisierung der User-Experience wird immer größer. Einige Beispiele für Machine Learning Implementierungen waren folgende:

- Dem User werden bestimmte Inhalte, z.B. auch ein Call-To-Action Button, erst gezeigt, wenn er eine Conversion-Wahrscheinlichkeit von 25% erreicht.

- Kategorisierung der User nach Personas/Styles, um ihnen personalisierte Inhalte zu liefern.

- Eine Webseite für Blumenverkauf startet eine Kategorisierung der User anhand der persönlichen Nachrichten zu den von ihnen gewählten Blumen, um ihnen beim nächsten Besuch direkt relevantere Blumenstraußtypen und -kategorien anzubieten.

Jede Personalisierung ist aber ohne Erkennen der User nicht möglich. Aktuell setzten die Browser ein Cookie für User-Tracking nur auf Geräteebene und eine der aufkommenden Fragen war, ob es demnächst möglich wird einen User Browser-weit und Geräte-unabhängig zu markieren (z.B. Foodprint).

Am Ende hörte man noch die Empfehlung für ein neues Heat Map Tool – Eyequant. Dieses soll sogar die Nutzung der Webseite hervorsagen können bzw. Abschätzungen dafür geben können.

Das Drumherum

Neben den spannenden Vorträgen und dem fachlichen Input, dem wir alle sehr viel abgewinnen konnten, hatten die Organisatoren auch für das leibliche Wohl der Teilnehmer bestens gesorgt (Danke Siteimprove!). Die geräumige Terrasse und die schönen Ausblicke ließen die Teilnehmer in den Pausen neue Energie tanken.

[av_gallery ids=’29606,29605,29607′ style=’thumbnails‘ preview_size=’portfolio‘ crop_big_preview_thumbnail=’avia-gallery-big-crop-thumb‘ thumb_size=’portfolio‘ columns=’3′ imagelink=’lightbox‘ lazyload=’avia_lazyload‘ av_uid=’av-jcud8s‘]

Der interessante und gelungene Tag, der für jeden etwas Neues zu bieten hatte und auch Gelegenheit zum Austausch untereinander bot, endete mit einem kurzen Wrap-Up von Peter O’Neil mit darauffolgenden Drinks und Afterpaty. Mehr dazu findet ihr auf der Veranstalter-Seite: http://copenhagen.measurecamp.org/